python爬虫程序开发很多时候都是会去使用Scrapy这个框架创建项目,那么在程序开发完成之后还需要将其部署到服务器上才可以远程访问和自动运行。而这篇文章就是来介绍python使用Scrapy框架开发的爬虫程序是如何部署服务器的,一起往下看看吧。

1.因为Scrapy框架提供了专门的服务器部署工具,先在命令行窗口内用pip命令将它们给下载安装好,示例如下所示:

pip install scrapyd pip install scrapy-client pip install scrapyweb

这三个工具中scrapyd就是用来创建服务器的,而scrapy-client它可以将整个项目打包之后发布到服务器上面,而scrapyweb则是用来管理服务器并且完成日志可视化分析处理的。

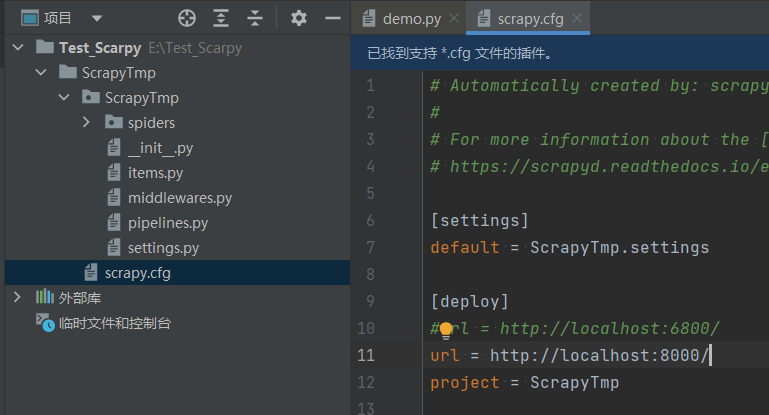

2.在上传项目之前需要在命令执行scrapyd这个命令来将服务器给打开,然后使用pycharm编辑器打开Scrapy项目并且打开项目文件之中的cfg文件,在其中添加一行配置项,示例如下:

url = http://localhost:8000/

3.然后使用快捷键Alt+F12打开终端窗口,在该窗口内需要先使用cd将工作目录切换到cfg文件所在的文件路径,然后再去执行下面这个命令就可以上传项目到服务器上了:

scrapyd-deploy scrapyd-deploy demo -p qcjob

第二个命令之中-p后面的是项目名称,这个不是根目录名称,而是使用Scrapy框架创建项目时的那个名称,根据自己的项目进行更改。

然后打开浏览器并输入指定网址即可启动爬虫程序,这个网址中的数据都是访问网站时会带上去的数据,具体根据自己爬虫程序更改,示例如下:

http://localhost:6800/schedule.json?project=qcjob&spider=job&key=java&time=0 #POST

以上就是关于“Scrapy爬虫项目怎么部署到服务器?Python爬虫程序Scrapy服务器如何部署”的全部内容了,希望对你有所帮助。