在Python众多的科技领域当中,爬虫的存在一直是独树一帜的;虽然其他语言也能进行网络数据的爬取,但是Python凭借更简洁的语法,更简单的逻辑而获得爬虫爱好者的喜爱。而代理IP的使用也是每一位爬虫使用者所需掌握的内容,那么什么是代理IP呢?

一、代理IP

在Python爬虫中,如果过多的访问同一个网站,会被网站的运维人员检测到进而封禁我们的IP地址,这个时候就需要我们用代理IP来代替我们自己的IP来进行访问

二、使用代理IP的原理

代理IP又叫做代理服务器,是服务端和个人浏览器中间的一座代理中转站;当浏览器请求访问时,返回的结果会先送到这个中转站然后在发送到你的浏览器上,而服务端检测到的访问数据都只是在这个中转站上,可以很好的防止个人IP被ben。

三、使用IP代理的方式

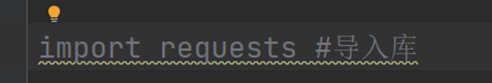

因为代理IP在Python中主要用在爬虫方面,所以我们先导入好爬虫所需要的第三方库

import requests # 导入库

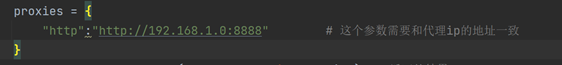

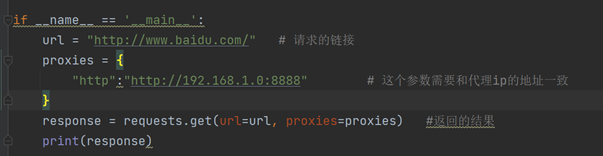

然后添加一个代理IP,可以根据自己的需要,添加多个代理IP,这样就是创建了一个IP代理池:

"http":"http://IP地址:端口号"

通过requests库的get请求,得到百度网页的返回内容,当然这个内容返回的结果首先要经过代理服务器然后才到我们自己的电脑浏览器上。

四、总结

目前,国内的代理IP服务商是非常众多,有收费也有不收费的;如果只是爬虫的需求,一般免费的代理IP都可以满足。不要将资源放在没有必要的地方,而是根据自己的需要合理分配资源。