一些小的python程序是可以只写在一个py文件之中的,而scrapy这种爬虫框架则需要通过搭建项目才能够去创建爬虫程序。而这一篇文章主要介绍的内容则是,python使用scrapy框架创建爬虫项目的详细教程,感兴趣的话可以一起往下看看。

1.首先需要打开文件夹并选择或者新建一个目录进入,因为创建出来的scrapy框架爬虫项目是要保存在文件目录下的,它本质上来说就是一个文件夹。然后在文件夹地址栏输入cmd并回车,就能够以当前路径作为工作目录进入到命令行中。

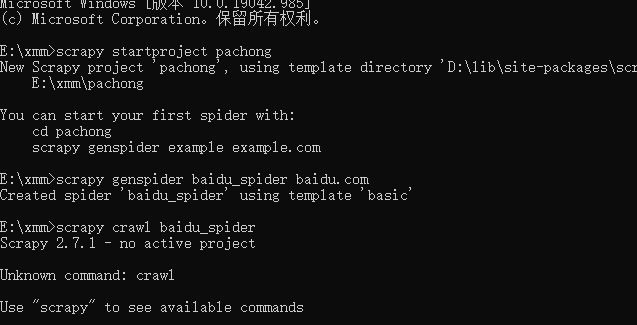

2.因为scrapy本身已经内置了可以使用它来创建项目的功能,所以不需要使用pycharm或者是vscode1等专业编辑工具也是一样的。在命令行中执行相关命令,就可以在当前目录下创建出scrapy框架构建的项目,命令如下:

scrapy startproject pachong

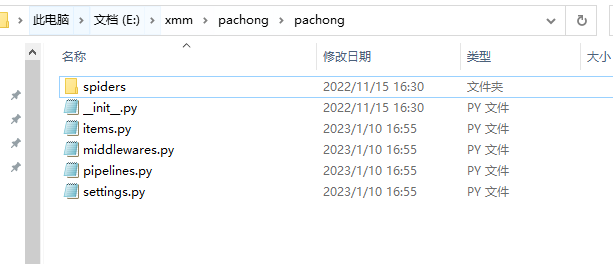

3.项目创建完成之后可以看到有一些文件夹和配置文件存在,需要注意别将这些文件给删除掉了。而具体执行数据爬取操作的爬虫脚本都是放在Spider文件夹之中的,所以我们还需要通过命令在这个文件夹中创建有模板的爬虫python文件,命令如下:

scrapy genspider baidu_spider baidu.com

4.等待命令执行完成之后就表示这个爬虫脚本创建完成了,而要抓取哪一个网站,以及数据抓取之后如何处理就要自己去编写代码了。代码编写完成之后同样是通过执行命令来运行这个爬虫程序,如下所示:

scrapy crawl baidu_spider

以上就是关于“Python怎么搭建scrapy框架项目?Python如何使用scrapy框架创建爬虫”的全部内容了,希望对你有所帮助。